Studio de recherche voiture autonome

Studio de recherche voiture autonome

Accélérer, étendre et soutenir la recherche sur la conduite autonome

Le studio de recherche sur les voitures autonomes Quanser est une plate-forme hautement extensible et puissante conçue spécifiquement pour la recherche universitaire. Utilisez-le pour relancer vos recherches et faire évoluer votre flotte de véhicules, tout en tirant parti de plusieurs environnements logiciels. Le studio vous apporte les outils et les composants dont vous avez besoin pour tester et valider la génération de jeux de données, la cartographie, la navigation, l’apprentissage automatique, l’intelligence artificielle et d’autres concepts avancés de conduite autonome.

![]()

BROCHURE

![]()

video

![]()

extrait simulink

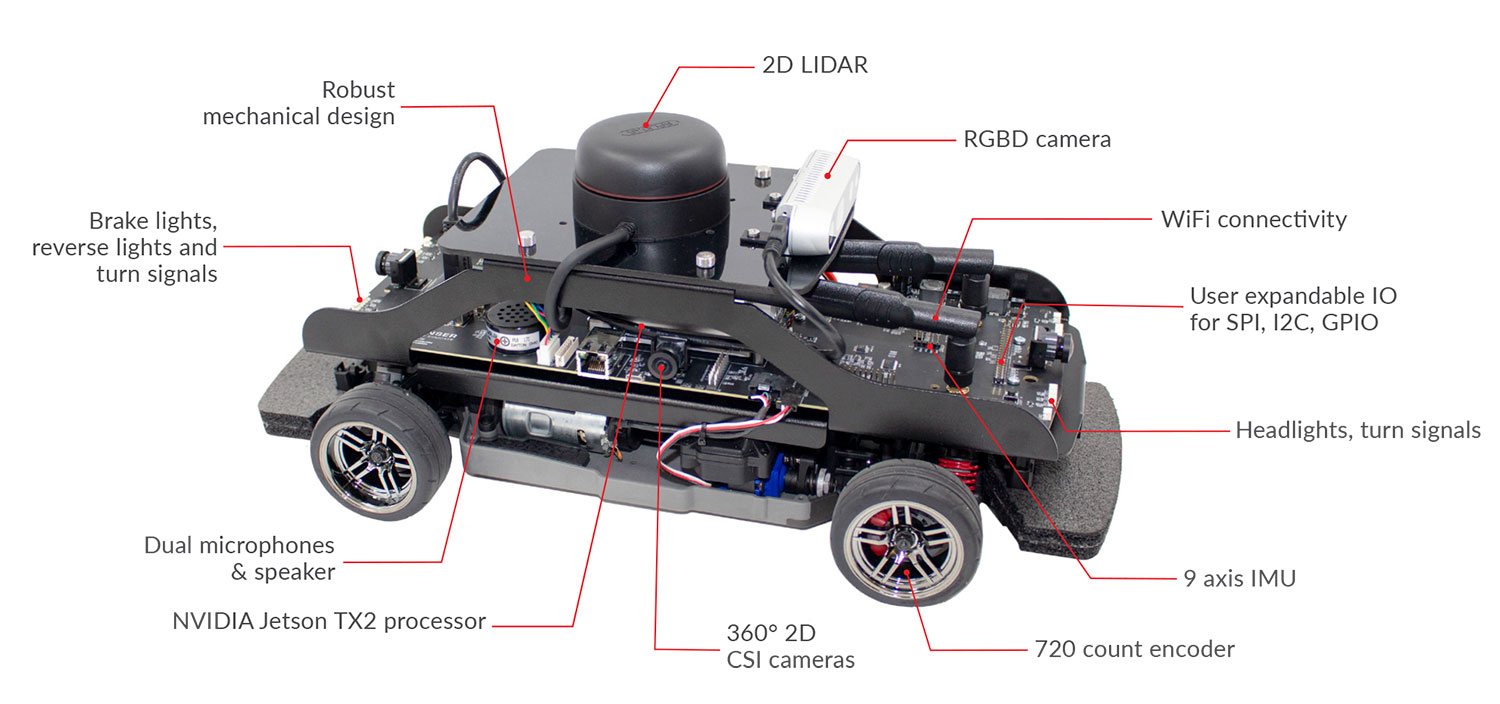

Au centre du studio de recherche sur les voitures autonomes, le QCar est un modèle de véhicule à architecture ouverte, alimenté par le superordinateur NVIDIA® Jetson ™ TX2 et équipé d'une large gamme de capteurs, caméras, encodeurs et extensible par l'utilisateur. IO.

S'appuyant sur un ensemble d'outils logiciels comprenant Simulink®, Python ™, TensorFlow et ROS, le studio permet aux chercheurs de créer des applications de haut niveau et de reconfigurer des processus de bas niveau pris en charge par des modules et des bibliothèques prédéfinis. À l'aide de ces blocs de construction, vous pouvez explorer des sujets tels que l'apprentissage automatique et la formation à l'intelligence artificielle, la réalité augmentée / mixte, le transport intelligent, les scénarios multi-véhicules et la gestion du trafic, l'autonomie coopérative, la navigation, la cartographie et le contrôle, etc.

| Logiciels et API supportés | QUARC Autonomous Software License |

| Quanser APIs | |

| TensorFlow | |

| TensorRT | |

| Python™ 2.7 & 3 | |

| ROS 1 & 2 | |

| CUDA® | |

| cuDNN | |

| OpenCV | |

| Deep Stream SDK | |

| VisionWorks® | |

| VPI™ | |

| GStreamer | |

| Jetson Multimedia APIs | |

| Docker containers avec support GPU | |

| Simulink® avec Simulink Coder | |

| Environnements de simulation et virtuel (Gazebo, QuanserSim) | |

| Développement Multi-language supporté avec Quanser Stream APIs pour des communications inter-process | |

| Unreal Engine |

| Véhicules | Station d contrôle | Equipements du studio de recherche |

|

|

|

| Dimensions | 39 x 21 x 21 cm |

| Weight (with batteries) | 2.7 kg |

| Power | 3S 11.1 V LiPo (3300 mAh) with XT60 connector |

| Operation time (approximate) | 2 hr 11 m (stationary, with sensors feedback) |

| 35 m (driving, with sensor feedback) | |

| Onboard computer | NVIDIA® Jetson™ TX2 |

| CPU: 2 GHz quad-core ARM Cortex-A57 64-bit + 2 GHz Dual-Core NVIDIA Denver2 64-bit | |

| GPU: 256-core NVIDIA Pascal™ GPU architecture , 1.3 TFLOPS (FP16) | |

| Memory: 8GB 128-bit LPDDR4 @ 1866 MHz, 59.7 GB/s | |

| LIDAR | LIDAR with 2k-8k resolution, 10-15Hz scan rate, 12m range |

| Cameras | Intel D435 RGBD Camera |

| 360° 2D CSI Cameras using 4x 160° FOV wide angle lenses, 21fps to 120fps | |

| Encoders | 720 count motor encoder pre-gearing with hardware digital tachometer |

| IMU | 9 axis IMU sensor (gyro, accelerometer, magnetometer) |

| Safety features | Hardware “safe” shutdown button |

| Auto-power off to protect batteries | |

| Expandable IO | 2x SPI |

| 4x I2C | |

| 40x GPIO (digital) | |

| 4x USB 3.0 ports | |

| 1x USB 2.0 OTG port | |

| 3x Serial | |

| 4x Additional encoders with hardware digital tachometer | |

| 4x Unipolar analog input, 12 bit, 3.3V | |

| 2x CAN Bus | |

| 8x PWM (shared with GPIO) | |

| Connectivity | WiFi 802.11a/b/g/n/ac 867Mbps with dual antennas |

| 2x HDMI ports for dual monitor support | |

| 1x 10/100/1000 BASE-T Ethernet | |

| Additional QCar features | Headlights, brake lights, turn signals, and reverse lights (with intensity control) |

| Dual microphones | |

| Speaker | |

| LCD diagnostic monitoring, battery voltage, and custom text support |